Chiêu trò lửa đảo bằng cách giả giọng nói với deepfake voice

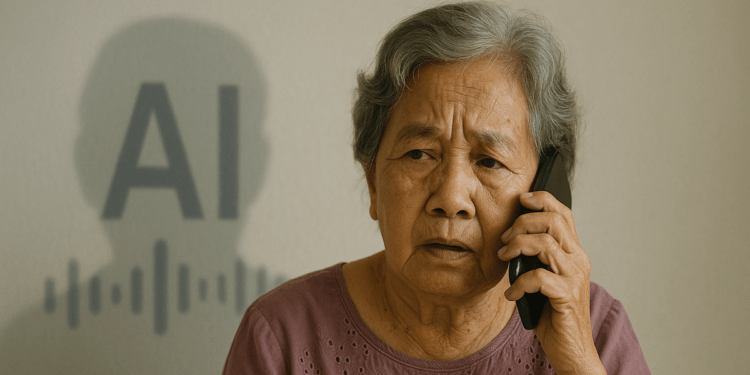

Trong thời đại trí tuệ nhân tạo phát triển nhanh chóng, giọng nói – một trong những yếu tố từng được xem là bằng chứng xác thực – nay đã trở thành công cụ nguy hiểm trong tay kẻ xấu. Công nghệ deepfake voice cho phép giả mạo giọng nói giống hệt người thật, tạo ra những cuộc gọi mạo danh tinh vi nhằm lừa đảo chiếm đoạt tài sản.

Vì sao deepfake voice đáng sợ?

Deepfake voice là công nghệ ứng dụng trí tuệ nhân tạo (AI) và machine learning để tạo ra giọng nói giả nhưng giống hệt giọng của một người thật.

Với sự hỗ trợ của các mô hình hiện đại như Tacotron, WaveNet, ElevenLabs hoặc các nền tảng clone giọng như Respeecher, kẻ gian chỉ cần từ 3 – 10 giây mẫu giọng là có thể tạo ra một bản deepfake đáng tin đến 95%.

Deepfake voice trở nên đặc biệt nguy hiểm vì khả năng bắt chước giọng nói gần như hoàn hảo, từ cách phát âm, ngữ điệu cho đến cả những tật nói riêng của từng người.

Điều này khiến nạn nhân rất khó phân biệt thật – giả, đặc biệt khi giọng nói đó là của người thân, bạn bè hay cấp trên họ.

Việc khai thác giọng nói cũng rất dễ dàng, khi ngày nay hầu hết mọi người đều để lộ âm thanh qua các nền tảng như TikTok, livestream trên mạng xã hội, podcast, hay các cuộc họp trực tuyến. Đáng lo ngại hơn, deepfake voice không để lại dấu vết trực quan như hình ảnh hay video, khiến việc điều tra trở nên khó khăn và nạn nhân dễ bị mất tiền oan uổng.

Chỉ cần vài giây mẫu giọng nói là đã có thể tạo ra một bản deepfake

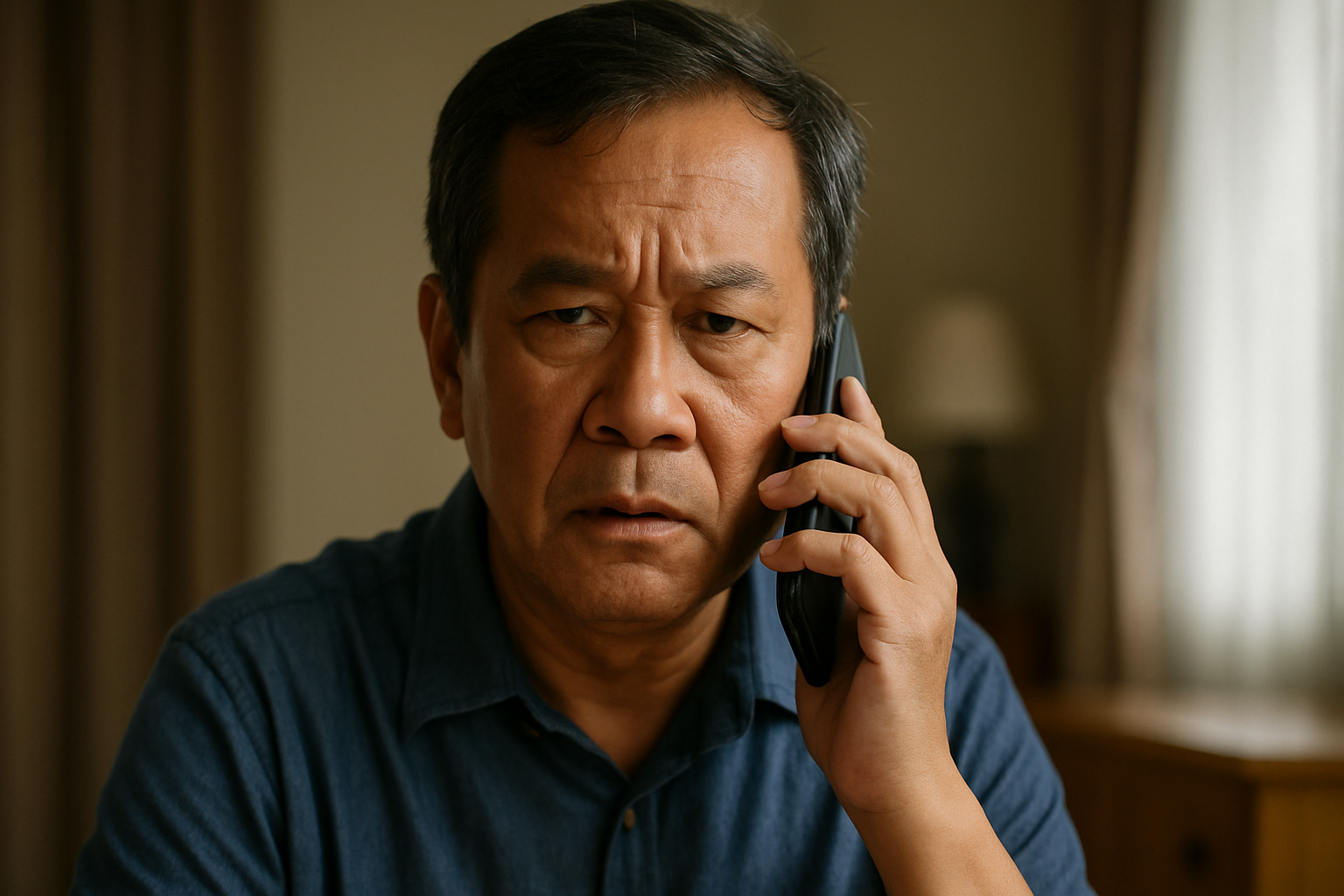

Các vụ lừa đảo bằng công nghệ deepfake voice đang ngày càng tinh vi, thường sử dụng một kịch bản quen thuộc: giả giọng người quen trong tình huống khẩn cấp để tạo tâm lý hoang mang và thúc ép nạn nhân chuyển tiền ngay lập tức.

Tại Việt Nam, đã có trường hợp một người mẹ nhận được cuộc gọi từ “con trai” thông báo bị tai nạn và cần tiền gấp. Ở Anh, một giám đốc công ty bị lừa hơn 240.000 USD sau khi nghe “sếp” yêu cầu chuyển tiền qua điện thoại. Một nhân viên hành chính cũng bị đánh lừa khi nhận cuộc gọi từ “sếp lớn” yêu cầu thanh toán cho một “đối tác chiến lược”…

Điểm chung trong các tình huống này là giọng nói giả được tái hiện giống hệt người thân, cấp trên, khiến nạn nhân tin tưởng tuyệt đối và không có thời gian để xác minh.

Luôn xác minh, đừng tin ngay

Trước sự gia tăng số vụ lừa đảo bằng deepfake voice, người dân được khuyến cáo không nên chuyển tiền chỉ dựa vào giọng nói qua điện thoại, dù giọng đó nghe giống hệt người thân. Thay vào đó, hãy gọi lại số cũ hoặc kiểm tra thông tin qua nhiều kênh khác nhau trước khi thực hiện bất kỳ giao dịch nào.

Nhiều chuyên gia cũng khuyến nghị nên thiết lập “mật khẩu nội bộ” trong gia đình hoặc doanh nghiệp để xác minh trong những tình huống bất thường.

Ngoài ra, cần hạn chế đăng tải các video có giọng nói rõ ràng lên mạng xã hội, đặc biệt là nội dung dài. Đặc biệt, nên chủ động cảnh báo và hướng dẫn nhóm đối tượng dễ bị tổn thương như người lớn tuổi hoặc ít tiếp xúc với công nghệ, vì đây là mục tiêu ưu tiên của các vụ lừa đảo bằng công nghệ cao.

Từ giọng nói của người thân, bạn bè, đồng nghiệp đều có thể bị làm giả

Tại nhiều quốc gia, cơ quan chức năng đã bắt đầu siết chặt quản lý công nghệ deepfake bằng khung pháp lý riêng.

Tại Mỹ, một số bang đã ban hành lệnh cấm sử dụng deepfake trong các chiến dịch bầu cử hoặc truyền tải thông tin sai lệch. Liên minh châu Âu (EU) thông qua Đạo luật AI (AI Act), yêu cầu các tổ chức phải minh bạch và cảnh báo rõ ràng nếu một nội dung được tạo ra bởi trí tuệ nhân tạo.

Trong khi đó, tại Việt Nam, dù chưa có quy định cụ thể dành cho deepfake voice, các hành vi liên quan có thể bị xử lý theo luật hiện hành, với các tội danh như lừa đảo chiếm đoạt tài sản, xâm phạm quyền riêng tư, hoặc giả mạo danh tính.

Tuy nhiên, thực tế cho thấy công nghệ đang phát triển với tốc độ vượt xa năng lực giám sát của luật pháp, để lại nhiều lỗ hổng mà các đối tượng xấu có thể lợi dụng.

Khi giọng nói không còn là bằng chứng

Giọng nói từng là thứ gắn bó mật thiết, đáng tin nhưng với deepfake voice, nó đã không còn là bằng chứng xác thực. Trong thời đại AI, mỗi cá nhân cần có kiến thức phòng vệ số, chủ động xác minh và luôn cảnh giác vì một cuộc gọi có thể là bẫy.

Lừa đảo và deepfake nguy hiểm khôn lường nhờ AI

Lừa đảo và deepfake nguy hiểm khôn lường nhờ AI